确保人工智能安全的挑战

关键要点

人工智能AI技术的快速发展带来了不断变化的安全风险,需要不断更新和评估安全措施。NIST 提供的新指导有助于理解当前的 AI 风险,但现有防御措施尚不够完善,需改善。安全行业应倡导双层次安全方法,包括预测性和主动性安全,确保 AI 系统的可靠性。采用新框架,利用 AI 自身识别和修复系统缺陷,以增强防御能力。在人工智能AI的安全保障方面,我们面临着一个复杂且不断变化的挑战。随着 AI 技术的发展,新攻击面和攻击策略所带来的风险也在增加。开发者、组织和政府必须采取适应性的方法,持续评估和更新安全措施。我们这个行业还需要认识到,快速技术发展所固有的风险,常常使安全成为次要关注点。

来自 NIST 的新指导 提高了我们对当前 AI 风险的理解,概述了当前的攻击技术,建立了共享的分类法,并审查了当前的缓解方法。然而,正如 NIST 的计算机科学家及出版贡献者 Apostol Vassilev 所指出的,现有防御措施“缺乏充分的保障,无法完全消除风险”,因此需要更好的方法。

为此,安全行业应倡导一种包含预测性和主动性安全的双层次方法,以创建安全可靠的 AI 系统。AI 开发人员应在初始设计阶段预见并主动应对潜在攻击,将强大的安全措施纳入 AI 系统本身。此外,我们建议采用一种新框架,利用 AI 本身主动识别新 AI 系统中的缺陷并制定强韧的防御策略。

预测性安全

降低已知风险的第一步是定义具体的安全措施和协议,以指导 AI 的开发和部署。例如,可以考虑在电子商务场景中部署自然语言处理NLP AI 模型作为客户支持聊天机器人。在这种情况下,在 NLP 模型的核心机制中实施强大的安全措施,可以帮助防止潜在的利用和滥用。

以下是 AI 客户支持聊天机器人的最佳实践安全措施示例:

黑洞加速器破解安全措施描述输入验证与净化确保 AI 系统具备严格的输入验证机制,有效净化用户输入。这可以防止恶意行为者注入有害命令或试图通过精心设计的输入操控系统。针对 NLP 模型的对抗性测试进行专门针对 NLP 模型的全面对抗性测试。这包括将模型暴露于故意制作的输入中,以利用其弱点。通过对 AI 系统施加各种对抗场景,开发者可以识别并加强潜在的薄弱环节,提高模型的韧性。持续监控与异常检测建立一个配备异常检测算法的持续监控系统。它能够实时识别 AI 行为中异常模式或偏差,快速检测可及时缓解潜在安全威胁,最大限度地减少恶意活动的影响。通过将这些具体的安全措施融入 NLP AI 模型的核心,开发者可以显著增强系统的安全性。

主动性安全

当今的多层神经网络模型及其庞大的训练数据集是 AI 安全的一大障碍。因此,大型语言模型LLMs及其他 AI 产品超出了人类团队探索潜在弱点的能力范围。

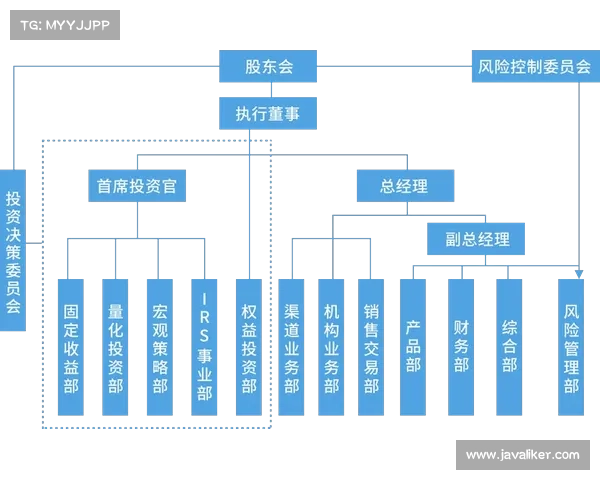

通过使用一种不同 AI 组件的框架,我们可以实现这些 AI 系统的主动性安全。这种创新方法的目标是创建一种适用于不同 AI 引入的强大安全系统,并通过一次性的投资促进组织 AI 投资组合的持续优化和加强。框架组成部分如下:

新 AI: 我们